Posted by Atsuhi Kojima, Researcher, Money Forward Lab.

この記事では自然言語処理に興味がある、あるいは研究開発に携わっているエンジニアや学生の方に向けて、マネーフォワードの研究機関である Money Forward Lab が取り組んでいる Large Langugage Model (LLM) の研究開発についてご紹介します。

LLM の指示追従性を向上させる学習手法として Supervised Fine-Tuning (SFT) があります。SFT モデルは、prompt と completion のペアで構成されるインストラクションデータを用意し、事前学習モデルに対して fine-tuning することで学習されます。

このようなインストラクションデータの作成は、GPT-4 などの学習済みモデルからの出力を利用する方法を除くと、人手で prompt と completion を記述する必要があり、アノテーションコストがとても高いです。そのため、日本語のインストラクションデータは、英語で作成されたインストラクションデータを日本語に翻訳することで得るアプローチが大半でした。

この問題を解決するため、Money Forward Lab では、日本語のインストラクションデータをフルスクラッチで作成するため、2023年9月より国立研究開発法人理化学研究所 革新知能統合研究センター 言語情報アクセス技術チーム(以降、「理研」)との共同研究を開始しました。

この共同研究の成果として、理研によって作成され、共同研究企業に提供されたインストラクションデータである ichikara-instruction を用いて学習された LLM をオープンソースで公開いたしました。なお、データセットは最新のものを利用しており、これには 4802 件のデータが含まれます。

このモデルは、鳳凰(houou)と命名され、Hugging Face にてLLAMA 2 licence で公開されています。 https://huggingface.co/moneyforward/houou-instruction-7b-v2

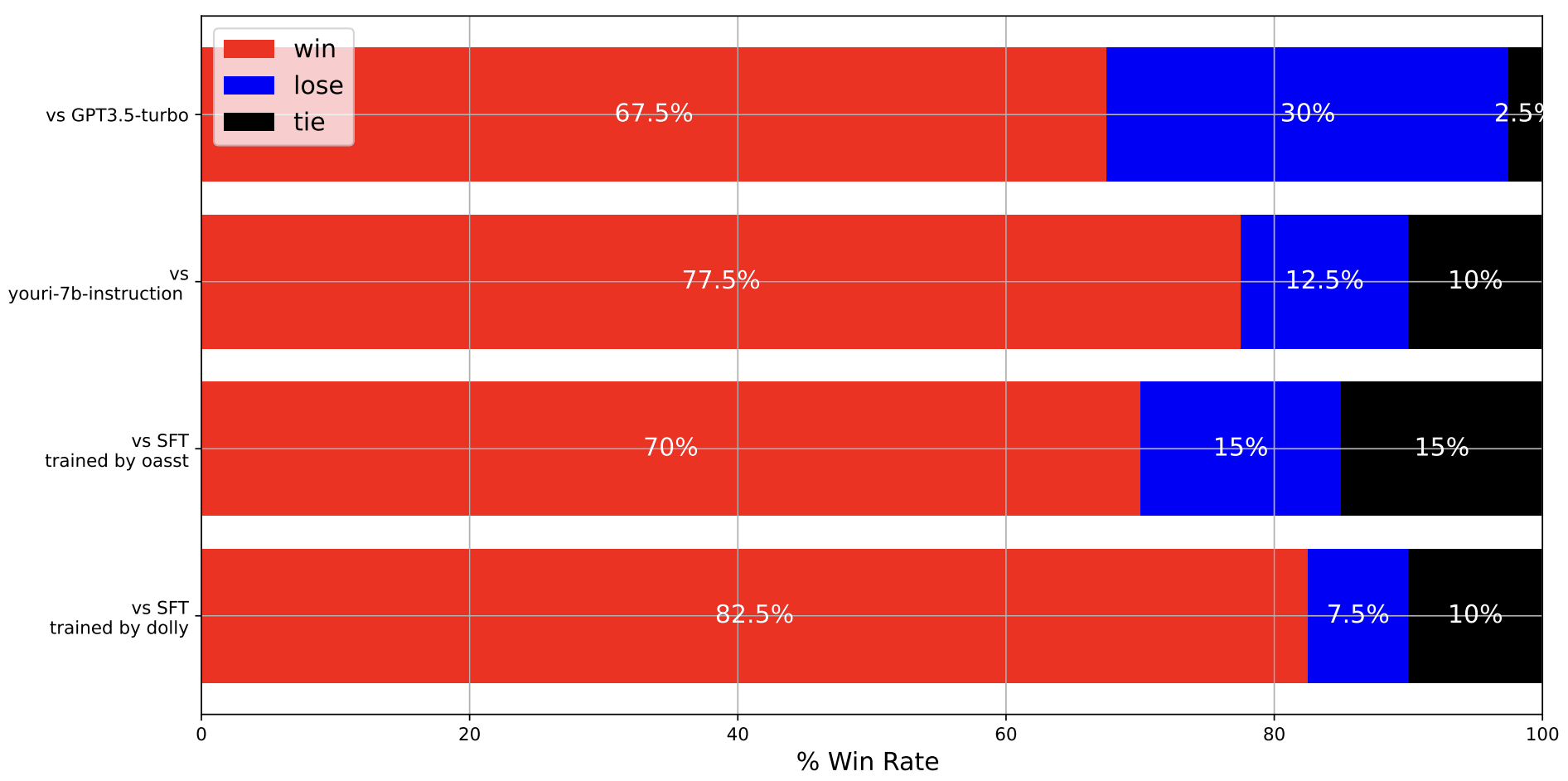

Rakuda Benchmark における houou の勝率

日本に関する40の自由形式の質問で構成される Rakuda Benchmarkを使って houou の性能を評価しました。実験では、効率的な評価のため、gpt-4 による自動評価を採用しました。

実験の結果、houou は、日本語に翻訳された dolly とOASST によってそれぞれ学習された SFT モデル性能を上回ることがわかりました。さらに、gpt-3.5-turbo-1106 との比較においても、houou は、 67.5%の質問 に対して gpt-3.5-turbo-1106 よりも優れた出力を行えることがわかりました。

実験の結果、houou は、日本語に翻訳された dolly とOASST によってそれぞれ学習された SFT モデル性能を上回ることがわかりました。さらに、gpt-3.5-turbo-1106 との比較においても、houou は、 67.5%の質問 に対して gpt-3.5-turbo-1106 よりも優れた出力を行えることがわかりました。

他のデータセットでの評価や、人手評価に関する詳細は2024年3月に神戸にて開催される言語処理学会第30回年次大会(NLP2024)で報告いたします。

NLP2024でのマネーフォワードの発表

マネーフォワードは、言語処理学会第30回年次大会において、houou の成果に関する論文も含め、自然言語処理に関する論文を3本発表いたします!

大規模言語モデル houou (鳳凰): 理研 ichikara-instruction データセットを用いた学習と評価,

小島淳嗣, 北岸郁雄LLMの出力結果に対する人間による評価分析と GPT-4による自動評価との比較分析.

関根聡, 小島淳嗣, 貞光九月, 北岸郁雄

※ 理研との共著論文Retrieval-augmented generation に基づく カスタマーサポートにおける返信メール自動生成の検討.

小島淳嗣

また、本会議にて、マネーフォワードは、プラチナスポンサー、および冠スポンサーを務められることを大変嬉しく思います! 会議や企業ブースにて皆様とお会いできるのを楽しみにしております!

Money Forward Lab では仲間を募集中です。